Newsletter #4 – 16.04.2024

Dziękujemy za subskrybowanie newslettera naukowego Pracowni Archiwistyki Webu CKC UW.

Dlaczego tak ważne jest zrozumienie zawartości naszych archiwów Webu

Na łamach “Forbesa” Kalev Leetaru, badacz i analityk danych, zastanawia się nad ograniczeniami współczesnych archiwów Webu i wpływem tych ograniczeń na to, jak widzimy historyczny internet:

„Czy archiwum powinno priorytetowo traktować treści rządowe będące źródłem informacji udostępnianej obywatelom przez rząd, witryny edukacyjne będące wynikiem działalności ośrodków edukacyjnych kraju, witryny komercyjne jako dowód na komercyjne wykorzystanie internetu, czy też witryny osobiste pozwalające spojrzeć na społeczeństwo obywatelskie? Czy archiwum powinno skupić swoje wysiłki na zachowaniu przynajmniej jednej kopii każdej istniejącej strony, aby uchwycić możliwie pełny zakres internetu, czy też powinno skupić się na stałym i regularym tworzeniu migawek (snapshots) mniejszego zestawu stron w celu, aby udokumentować ewolucję internetu?”

https://www.forbes.com/sites/kalevleetaru/2015/11/25/why-its-so-important-to-understand-whats-in-our-web-archives/?sh=365394ec3f8c

Nowe narzędzie do pobierania stron…

Monolith to program działający w terminalu (Command Line Interface), pozwalający na szybkie zapisywanie nawet skomplikowanych stron internetowych do pojedynczych plików HTML – pobrane strony odtwarzalne będą nawet bez połączenia internetowego. Warto przypomnieć, że pliki HTML nie są standardowym formatem generowania i przechowywania archiwów Webu (jest nim format WARC).

https://github.com/Y2Z/monolith

…oraz pracy z archiwami Webu

Warchaeology to narzędzie działające w terminalu, ułatwiające pracę z plikami WARC. Oprogramowanie jest rozwijane przez Norweską Bibliotekę Narodową

https://nlnwa.github.io/warchaeology/

Jak opisywać jakość archiwów Webu?

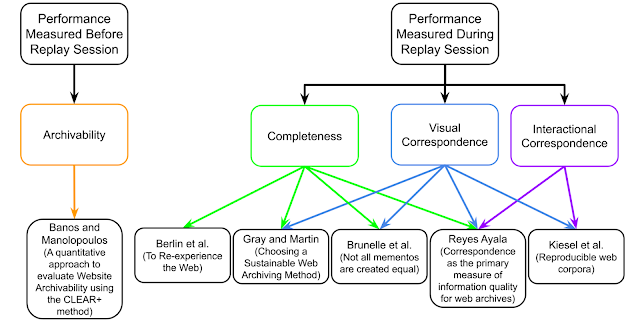

Na blogu Web Science and Digital Libraries Research Group (WebSciDl) opublikowano przegląd metod analizy jakości archiwów Webu. Jak wiadomo, każda archiwizacja obiektu WWW tworzy nie jej kopię, ale niedoskonałą interpretację. Niektóre kategorie pomiaru wydajności archiwizacji i odtwarzania (replaying) stron internetowych to archiwizowalność (archivability), zgodność wizualna (visual correspondence), kompletność i zgodność interakcyjna – ta ostatnia oznaczająca możliwość wykonywania tych samych interakcji na zarchiwizowanej stronie internetowej co na stronie dostępnej w internecie (live web).

https://ws-dl.blogspot.com/2024/03/2024-03-21-surveying-recent-work-on.html?spref=tw

Surfowanie po internecie lat 90. (prelekcja)

Zapraszamy na spotkanie z archiwistyką Webu podczas festiwalu Koderek (27 kwietnia, Warszawa):

„Czy wiesz, że internet da się archiwizować? Możesz robić to samodzielnie 🙂 Podczas spotkania porozmawiamy o archiwach WWW, Wayback Machine i czarnej dziurze cyfrowego dziedzictwa”

Festiwal Koderek to wydarzenie przybliżające dzieciom, młodzieży oraz dorosłym świat związany z nowymi technologiami, przedsiębiorczością i nowoczesną edukacją. Konferencja jest realizowana w pełni pro publico bono i jest darmowa dla uczestników. Zapisy na warsztaty rozpoczną się 17 kwietnia na stronie https://koderek.edu.pl

Marcin Wilkowski (m.wilkowski@uw.edu.pl)